La

era

de

la

inteligencia

artificial

generativa

nos

ha

traído

herramientas

asombrosas,

pero

también

un

desafío

mayúsculo:

la

desinformación.

Aunque

nuestra

exposición

constante

a

imágenes

creada

por

IA

nos

ha

hecho

más

escépticos,

un

reciente

estudio

de

Microsoft

demuestra

que

todavía

somos

muy

fáciles

de

engañar.

Y

para

probarlo,

han

lanzado

un

test

online

que

te

dejará

comprobarlo.

El

estudio,

que

analizó

las

respuestas

de

12.500

participantes

ante

287.000

imágenes,

concluyó

que

los

humanos

tenemos

una

tasa

de

acierto

de

apenas

el

63%

a

la

hora

de

diferenciar

una

foto

real

de

una

sintética.

Algo

que

puede

afectar

directamente

a

lo

que

vemos

en

las

redes

sociales,

donde

hay

multitud

de

imágenes

y

vídeos

que

a

veces

podemos

dudar

si

es

IA

o

realidad.

Y

es

que

no

somos

perfectos

cuando

el

resultado

de

la

IA

ha

sido

muy

logrado.

cuando

MICROSOFT

lanzaba

anuncios

ANTI-GOOGLE

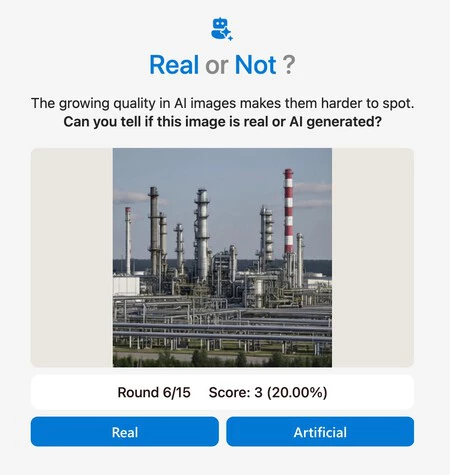

Ponte

a

prueba:

el

quiz

de

Microsoft

que

revela

nuestras

debilidades

Y

seguramente

alguna

vez

has

dicho «yo

sí

sé

diferenciar

bien

una

imagen

hecha

con

IA».

Pues

ahora

puedes

demostrarlo.

Microsoft

ha

creado

el

Real

or

Not

Quiz,

un

test

rápido

donde

se

presentan

15

imágenes

aleatorias.

Algunas

son

de

bancos

de

imágenes

de

stock,

otras

son

creaciones

con

modelos

como

Midjourney

o

DALL-E.

El

objetivo

es

simple:

decidir

si

son

reales

o

no.

Personalmente,

tras

haber

hecho

varios

intentos

con

este

Quiz,

he

descubierto

lo

difícil

que

puede

ser

diferenciar

algunas

imágenes

hechas

con

IA

de

la

realidad

por

lo

bien

hechas

que

están.

Y

es

que

cuando

pensamos

en

IA

nos

puede

venir

a

la

mente

la

típica

imagen

qeu

tiene

un

estilo

cartoon,

pero

cuando

se

usa

un

buen

prompt

en

una

buena

IA

el

resultado

es

muy

diferente.

Y

como

yo,

los

resultados

del

estudio

a

gran

escala

que

realizó

Microsoft

muestra

que

nos

equivocamos

mucho.

Como

consideraciones,

los

humanos

somos

ligeramente

mejores

a

la

hora

de

identificar

retratos

falsos

con

una

tasa

de

acierto

del

65%.

Pero

si

hablamos

de

los

deepfakes

creados

con

la

tecnología

GAN,

se

engaña

al

55%

de

los

participantes.

Pero

cuando

las

imágenes

no

contienen

a

seres

humanos,

como

por

ejemplo

en

paisajes,

nuestra

precisión

baja

bastante

y

es

más

fácil

que

podamos

decir

que

una

imagen

es

completamente

real

cuando

ha

sido

generada

con

IA.

El

truco

está

en

la

imperfección

Irónicamente,

una

de

las

razones

por

la

que

los

deepfakes

GAN

siguen

funcionando

tan

bien

es

porque

su

estética

se

asemeja

a

la

de

una

fotografía

de

baja

calidad,

con

menos

detalles

que

los

modelos

de

IA

suelen

fallar

en

replicar.

Nos

hemos

acostumbrado

tanto

a

la

estética

hiperrealista

y

pulida

de

las

IA

modernas

que,

cuando

algo

parece

una

foto

mediocre,

nuestro

cerebro

tiende

a

verlo

como

algo

completamente

real.

El

estudio

también

destaca

cómo

los

creadores

de

imágenes

están

afinando

sus

prompts

para

lograr

un

mayor

realismo.

Algunas

técnicas

incluyen:

-

Añadir

nombres

de

archivos

genéricos

en

el

prompt

como

por

ejemplo ‘IMG_4587.jpg’,

para

que

la

IA

imite

la

estética

de

una

fotografía

causal. -

Usar

fotografías

reales

como

guía

para

que

use

su

estética

en

lo

que

vaya

a

generar. -

Mantener

niveles

de

ruido

y

brillo

similares

a

los

de

una

fotografía

auténtica.

Pero

lo

más

fascinante

de

este

estudio,

es

ver

como

las

imágenes

que

más

confundieron

a

todos

los

que

participaron

eran

completamente

reales.

Las

tres

imágenes

con

una

tasa

de

identificación

más

baja

eran

imágenes

auténticas.

Y

todas

con

tasas

de

acierto

realmente

bajas

del

12,

14

y

18%.

¿Qué

tienen

en

común

todas

estas

imágenes?

Todas

muestras

al

ejército

estadounidense

en

escenarios

inusuales,

con

condición

de

iluminación,

saturación

de

color

y

velocidad

de

obturación

atípicas.

Esto

sugiere

que

nuestro

cerebro

tiene

un

sesgo

hacia

lo

que

considera ‘normal’

en

la

fotografía.

Cuando

una

imagen

se

sale

de

ese ‘canon’

que

tenemos

en

nuestra

mente

es

más

probable

que

digamos

que

es

completamente

falsa.

Y

esto

es

algo

crucial.

Entender

qué

tipo

de

imágenes

y

prompts

son

más

efectivos

para

engañar

al

ojo

humano

es

relevante

para

poder

crear

herramientas

que

persigan

la

desinformación.

Y

es

que

a

medida

que

estas

técnicas

se

van

perfeccionando,

los

humanos

vamos

a

poder

ser

persuadidos

por

información

completamente

errónea

y

cambiar

nuestro

pensamiento.

Por

ello,

la

compañía

insiste

en

que

este

estudio

es

un

recordatorio

de

la

importancia

crítica

de

etiquetar

de

forma

clara

y

transparente

todo

el

contenido

generado

por

inteligencia

artificial.

La

línea

entre

lo

real

y

lo

sintético

se

difumina,

y

la

necesidad

de

herramientas

de

verificación

es

más

urgente

que

nunca.

Imágenes

|

En

Genbeta

|

Cualquiera

ha

podido

entrar

a

tus

conversaciones

con

ChatGPT

a

través

de

Google,

pero

solo

si

las

tenías ‘públicas’