Europa lleva meses trabajando en una legislación que regule la inteligencia artificial, pero su primer borrador es preocupante por restrictivo. En Estados Unidos están estudiando cómo regularla, y para averiguarlo han preguntado a Sam Altman, CEO de OpenAI y máximo responsable del desarrollo de GPT-4 y ChatGPT. Esto es lo que él opina.

Declaración ante el Congreso. Altman declaró ayer ante el Congreso de los Estados Unidos para tratar de explicar a los gobernantes del país cuáles son para él los siguientes pasos a la hora de regular la inteligencia artificial. El CEO de OpenAI dejó claro que «entendemos que la gente esté ansiosa sobre cómo la IA puede cambiar nuestra forma de vida. Nosotros también lo estamos«.

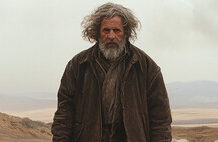

La amenaza existe. En los últimos tiempos estamos viendo cómo diversos expertos alertan del peligro que pueden llegar a suponer estos sistemas de inteligencia artificial. El más reciente y conocido es el de Geoffrey Hinton, calificado como «el padrino de la IA» que expuso los riesgos que plantea esta tecnología. Para Altman la amenaza existe, y señaló que esta industria podría «causar daños signitificativos al mundo» y que «si esta tecnología se equivoca, puede equivocarse mucho».

Una agencia global para controlarla. La propuesta de este directivo fue la de crear una agencia estadounidense o global que sería la encargada de gestionar cómo se utilizan los sistemas de inteligencia artificial para restringir o no esos usos. La forma de habilitar y restringir esos usos sería para Altman obvia.

Licenciar. Según Altman, se necesitaría algún tipo de mecanismo para licenciar la inteligencia artificial. La agencia encargada de controlar el desarrollo y uso de IA podría así imponer límites que bloquearían a modelos de IA para que no pudieran»autoreplicarse y autoimplantarse a lo loco».

Las licencias favorecen a las Big Tech. Pero claro, ese modelo de licencias es especialmente ventajoso para empresas como OpenAI, Google o Anthropic, que desarrollan estos modelos y luego venden el acceso a su API. La propuesta de Altman no es en ningún caso altruista, y es una interesante respuesta a la amenaza que estas empresas están viendo en los modelos de IA Open Source.

Las licencias complicarían las cosas para el Open Source. Un documento filtrado de Google mostraba cómo «El Open Source nos puede eclipsar» en el campo de la IA. Estos modelos están demostrando ser más ágiles y rápidos a la hora de lograr equiparar sus prestaciones a las de modelos propietarios como GPT-4. Sin embargo, quienes los desarrollan tendrían en ese modelo de licencias un potencial obstáculo, ya que probablemente sea difícil para ellos establecer límites robustos y controles para lograr limitar cóo la gente los usa: al ser Open Source, la gente podría modificar el código para saltarse dichos límites.

Ni tanto ni tan poco. El debate generado en este campo demuestra que la solución al problema de la regulación es muy compleja: no es conveniente ser demasiado restrictivos —lo que impediría aprovechar la tecnología y lograr que evolucionara—, pero tampoco dejar que los modelos de IA campen a sus anchas. Ni la UE ni EEUU parecen tener claro cómo lograr una regulación adecuada, pero el propio estado de la tecnología, incipiente y con un futuro tan incierto como su potencial, no ayuda.