Existe

un

benchmark

que

trata

de

puntuar

la

inteligencia

de

los

modelos

de

IA

con

una

particularidad:

su

resolución

es

extremadamente

difícil

para

los

modelos

de

IA,

pero

fácil

para

el

razonamiento

humano.

La

primera

competición

para

alcanzar

la

máxima

puntuación

de

este

benchmark

(ARC-AGI),

fue

superada

por

el

modelo

o3

(low)

de

OpenAI

en

un

75,7%

y

en

un

87,5%

(o3

high).

A

OpenAI

le

llevó

cuatro

años

pasar

en

2020

de

un

0%

con

GPT-3

a

un

5%

en

2024

con

GPT-4o.

Y

dado

que

los

modelos

de

razonamiento

profundo

son

cada

vez

más

sofisticados,

ARC-AGI

vuelve

con

una

versión

mejorada

de

su

benchmark

que

se

lo

pondrá

muy

difícil

a

los

modelos

de

IA

del

momento,

y

que

también

podemos

resolver

nosotros

mismos.

ARC-AGI,

un

test

sorprendentemente

difícil

para

la

IA,

pero

fácil

para

los

humanos

En

2019,

François

Chollet

-creador

de

Keras,

una

biblioteca

de

aprendizaje

profundo

de

código

abierto

adoptada

por

más

de

dos

millones

de

desarrolladores-,

publicó ‘On

the

Measure

of

Intelligence‘,

donde

introdujo

el ‘Corpus

de

abstracción

y

razonamiento

para

la

inteligencia

general

artificial’

(ARC-AGI)

de

referencia

para

medir

la

inteligencia.

Desde

entonces,

se

ha

consolidado

como

un

test

fiable

que

prueba

las

capacidades

de

una

IA

donde

los

participantes

independientes

y

compañías

ponen

a

prueba

sus

soluciones

en

una

competición,

la

ARC

Prize.

En

2025,

la

competición

se

realizará

sobre

ARC-AGI

2,

con

grandes

mejoras

respecto

a

su

predecesor.

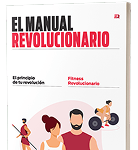

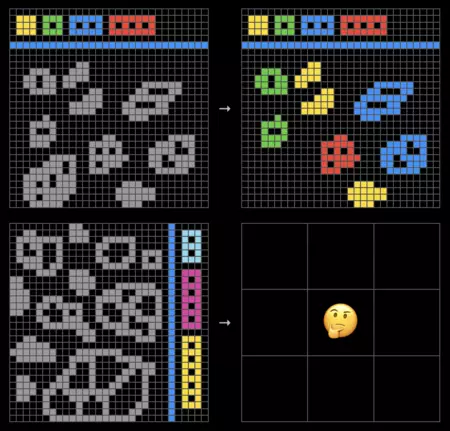

Resultados

de

múltiples

modelos

de

IA

en

ARC-AGI

2.

Imagen:

ARC

Prize

El

nuevo

conjunto

de

pruebas

ha

sido

diseñado

específicamente

para

desafiar

el

razonamiento

de

los

modelos

de

IA

(aunque

el

objetivo

es

testear

las

capacidades

de

una

AGI)

,

manteniendo

un

equilibrio

entre

su

dificultad

extrema

para

la

IA

y

su

accesibilidad

para

los

humanos.

Una

de

las

mejoras

clave

de

ARC-AGI-2

es

el

aumento

del

número

de

tareas

en

todos

los

conjuntos

de

evaluación,

pasando

de

100

a

120.

Esta

ampliación

busca

ofrecer

una

mayor

diversidad

y

complejidad

en

los

retos

planteados.

Además,

se

han

eliminado

todas

aquellas

tareas

que

podían

ser

resueltas

mediante

estrategias

de

fuerza

bruta

o

mediante

enfoques

algorítmicos

predefinidos.

De

este

modo,

el

desafío

se

centra

en

el

desarrollo

de

una

verdadera

capacidad

de

razonamiento

en

las

IA,

en

lugar

de

depender

de

soluciones

basadas

en

una

búsqueda

exhaustiva

o

lenguajes

específicos.

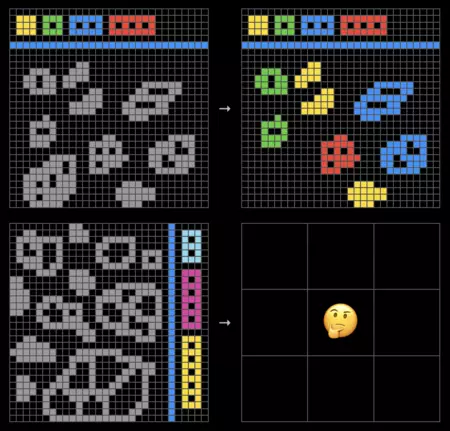

Uno

de

los

miles

de

puzles

que

cuenta

ARC-AGI

2.

Imagen:

ARC

Prize

Otra

novedad

importante

es

la

incorporación

de

pruebas

que

abordan

aspectos

clave

del

pensamiento

lógico,

como

la

interpretación

simbólica,

el

razonamiento

composicional

y

la

aplicación

de

reglas

contextuales.

Se

ha

demostrado

que

los

sistemas

de

IA

tienen

serias

dificultades

para

asignar

significado

a

símbolos,

combinar

múltiples

reglas

simultáneamente

o

adaptar

sus

respuestas

en

función

del

contexto.

Mientras

tanto,

cualquier

persona

puede

resolver

estos

problemas

con

naturalidad.

Para

garantizar

la

validez

de

estos

resultados,

todas

las

tareas

han

sido

sometidas

a

pruebas

con

personas

reales

en

un

estudio

controlado,

asegurando

que

los

conjuntos

de

evaluación

sean

comparables

y

estadísticamente

sólidos.

De

hecho,

si

tienes

curiosidad,

puedes

ponerte

tú

también

a

prueba

resolviendo

los

mismos

puzles

a

los

que

los

modelos

de

IA

se

enfrentan

con

este

benchmark.

Herramienta

web

para

resolver

los

puzles

de

ARC-AGI

Para

ello,

lo

único

que

tienes

que

hacer

es

dirigirte

al

siguiente

enlace

y

seleccionar

el

nivel

de

dificultad

y

test

(v1

y

v2,

ambos

en

versiones

fáciles

y

difíciles).

Los

puzles

muestran

composiciones

de

figuras

que

nosotros

tendremos

que

resolver

en

base

a

los

ejemplos

que

nos

exponen.

En

la

web

podemos

editar

los

cuadros,

copiar

desde

los

ejemplos,

rellenar

con

colores

las

zonas

y

más.

Una

vez

tengamos

lista

nuestra

solución,

tendremos

que

validarla.

Entre

los

cambios

en

la

competición

de

2025

también

han

traído

mejoras

significativas.

El

premio

principal

ha

aumentado

de

600.000

a

700.000

dólares

para

los

que

logren

superar

el

benchmark,

manteniendo

los

premios

adicionales

para

la

mejor

puntuación

y

la

mejor

publicación

científica.

Además,

los

recursos

computacionales

disponibles

para

los

participantes

se

han

duplicado,

lo

que

permite

realizar

pruebas

más

intensivas

sin

comprometer

la

calidad

de

las

soluciones.

Para

reforzar

la

transparencia

y

evitar

el

sobreajuste,

los

equipos

deberán

hacer

públicas

sus

soluciones

antes

de

recibir

la

evaluación

final

sobre

el

conjunto

privado

de

tareas.

Asimismo,

se

han

introducido

mejoras

en

la

clasificación

en

tiempo

real

de

la

plataforma

Kaggle,

donde

las

puntuaciones

se

basarán

en

un

conjunto

semi-privado

de

pruebas,

con

la

evaluación

definitiva

realizándose

solo

al

final

de

la

competición.

Otra

novedad

es

la

ampliación

del

periodo

de

participación,

que

ahora

se

extiende

de

marzo

a

noviembre

de

2025,

ofreciendo

más

tiempo

para

la

investigación

y

el

desarrollo

de

estrategias.

El

reto

planteado

por

ARC-AGI-2

ha

demostrado

ser

insuperable

para

las

soluciones

actuales

de

inteligencia

artificial.

Mientras

que

los

modelos

basados

únicamente

en

grandes

modelos

de

lenguaje

apenas

logran

resultados

en

torno

al

0

%,

incluso

las

soluciones

más

avanzadas,

como

o3

de

OpenAI,

no

superan

el

5

%.

En

contraste,

cada

una

de

las

tareas

ha

sido

resuelta

por

al

menos

dos

participantes

humanos

en

menos

de

dos

intentos,

lo

que

evidencia

la

brecha

existente

entre

el

razonamiento

humano

y

el

procesamiento

algorítmico

actual.

Imagen

de

portada

|

AGI

Prize