La llegada del navegador ChatGPT Atlas, lanzado recientemente por OpenAI para macOS (está previsto su lanzamiento también en otros SO), ha marcado un nuevo hito en la integración entre inteligencia artificial y navegación web. Sin embargo, junto con el entusiasmo inicial por sus funciones ‘inteligentes’, comienzan a aflorar serias preocupaciones sobre la seguridad y la privacidad de los usuarios.

El lanzamiento de Atlas coloca a OpenAI en competencia directa con gigantes como Google, Microsoft o Brave, que también están explorando potenciar sus navegadores con IA. Sin embargo, la magnitud de las capacidades de Atlas —su autonomía, su memoria y su integración con ChatGPT— lo convierten en un experimento mucho más ambicioso y, según algunos expertos, más peligroso.

De hecho, expertos en ciberseguridad, investigadores y organizaciones defensoras de la privacidad ya advierten que esta nueva generación de navegadores basados en IA podría abrir una caja de Pandora de riesgos inéditos en el entorno digital.

Un navegador con inteligencia propia

ChatGPT Atlas no es un navegador convencional. Según el anuncio oficial de OpenAI, su principal atractivo radica en la posibilidad de mantener una conversación con ChatGPT directamente junto a la página web que el usuario visita. Esta función permite al asistente comprender el contexto de lo que se está viendo, resumir, analizar o incluso ejecutar acciones dentro del propio sitio.

Además, introduce dos características revolucionarias —y potencialmente problemáticas—:

- Las ‘memorias del navegador’, que permiten a ChatGPT recordar información de las búsquedas y del comportamiento del usuario a lo largo del tiempo para ofrecer respuestas más personalizadas.

- El ‘modo agente’, mediante el cual ChatGPT puede navegar e interactuar de forma autónoma con sitios web, desde hacer compras online hasta reservar un hotel o completar formularios.

En teoría, estas funciones están diseñadas para mejorar la productividad. En la práctica, implican que el navegador debe acceder, interpretar y almacenar grandes cantidades de datos personales, lo que eleva de manera exponencial la superficie de ataque para ciberdelincuentes y el riesgo de fugas de información.

En el mismo momento de su lanzamiento, el navegador empezó a ser objeto de escrutinio por parte de la comunidad de expertos en seguridad informática

Las alertas de la comunidad de seguridad

Según un informe de Axios, Atlas recopila más datos sobre sus usuarios que cualquier otro navegador del mercado, lo que despertó alarmas entre defensores de la privacidad. Investigadores de SquareX incluso lograron engañar al navegador para que visitara un sitio malicioso camuflado como la página de inicio de sesión de Binance, la popular plataforma de criptomonedas.

Entre los problemas más preocupantes destaca la vulnerabilidad ante ataques de ‘prompt injection’: una técnica mediante la cual un atacante esconde instrucciones maliciosas en una página web o correo electrónico, con el objetivo de hacer que la IA ejecute acciones no autorizadas o revele información sensible. En el caso de Atlas, eso podría significar que el asistente compre un producto no deseado, borre archivos del sistema o incluso acceda a contactos personales.

Steve Wilson, cofundador del proyecto OWASP Gen AI Security, resumió la situación con estas palabras:

«Las guerras de los navegadores ya no giran en torno a pestañas o motores de búsqueda; sino sobre si podemos evitar que nuestros nuevos asistentes digitales se vuelvan contra nosotros».

Cuando la memoria del navegador se convierte en una amenaza

Uno de los aspectos más inquietantes es la función de ‘memorias’ del navegador. Aunque OpenAI afirma que los datos se almacenan de forma privada y controlada por el usuario, las pruebas realizadas por la tecnóloga Lena Cohen, de la Electronic Frontier Foundation, revelaron que Atlas llegó a memorizar búsquedas sobre salud reproductiva e incluso el nombre de una médico real. Este tipo de información, que en algunos estados de EE. UU. ha sido utilizada con fines judiciales, plantea un grave riesgo en contextos donde los derechos a la privacidad médica o reproductiva están en disputa.

OpenAI asegura que Atlas no debería recordar información médica, financiera o administrativa sensible, y ofrece opciones para eliminar recuerdos o impedir que el navegador los almacene. Pero la sola existencia de esa memoria persistente abre interrogantes sobre su gestión, posibles filtraciones y el alcance real del control que el usuario puede ejercer sobre ella.

La defensa de OpenAI

Ante el creciente escrutinio, OpenAI ha salido a explicar las medidas implementadas para mitigar riesgos. En un comunicado publicado por el CISO de la compañía, Dane Stuckey, se reconocen las limitaciones actuales de la tecnología:

«Las inyecciones de prompt siguen siendo un problema de seguridad no resuelto. Nuestros adversarios dedicarán tiempo y recursos significativos para intentar engañar al agente de ChatGPT».

No obstante, la empresa detalla una serie de capas de protección integradas en Atlas:

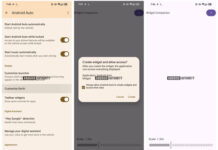

- Entrenamiento del modelo para ignorar instrucciones maliciosas, mediante técnicas de refuerzo.

- Modos de seguridad como ‘logged out mode’, donde el agente actúa sin acceder a las credenciales del usuario, ideal para tareas que no requieren iniciar sesión.

- ‘Watch mode’, que exige que el usuario mantenga activa la pestaña cuando el agente interactúa con sitios sensibles, pausando las acciones si el usuario cambia de ventana.

- Controles de eliminación de recuerdos y restricciones de sistema, que impiden al agente ejecutar código o descargar archivos.

Estas medidas apuntan a construir una relación de confianza entre el usuario y su asistente digital, pero incluso el propio Stuckey reconoce que el desafío está lejos de resolverse por completo.

Vía | Axios

Imagen | Marcos Merino mediante IA